איך משווים בין מודלי שפה גדולים?

השוואה בין מודלי שפה אולי נשמעת כמו משימה טריוויאלית, אבל בפועל זה לא כל כך פשוט.

השיטה המקובלת ביותר להערכת מודלים היא האמצעות מבחנים אמריקאים מאתגרים, המבחן הכי שכיום נחשב לבנצ'מרק של התחום נקרא MMLU - Massive multi-task Language Understanding.

המבחן כולל שאלות ידע כללי ממגוון רחב של תחומים: ביולוגיה, כלכלה, היסטוריה, פילוסופיה, אסטרונמיה וכו'. המודל עונה על השאלות ובסופו מקבל ציון מספרי, בדיוק כמו מבחן אמריקאי באוניבסיטה.

אז איפה הבעיה?

הבעיה המרכזית היא שהתוצאות לא תמיד עקביות. הנה דוגמה מהתקופה האחרונה:

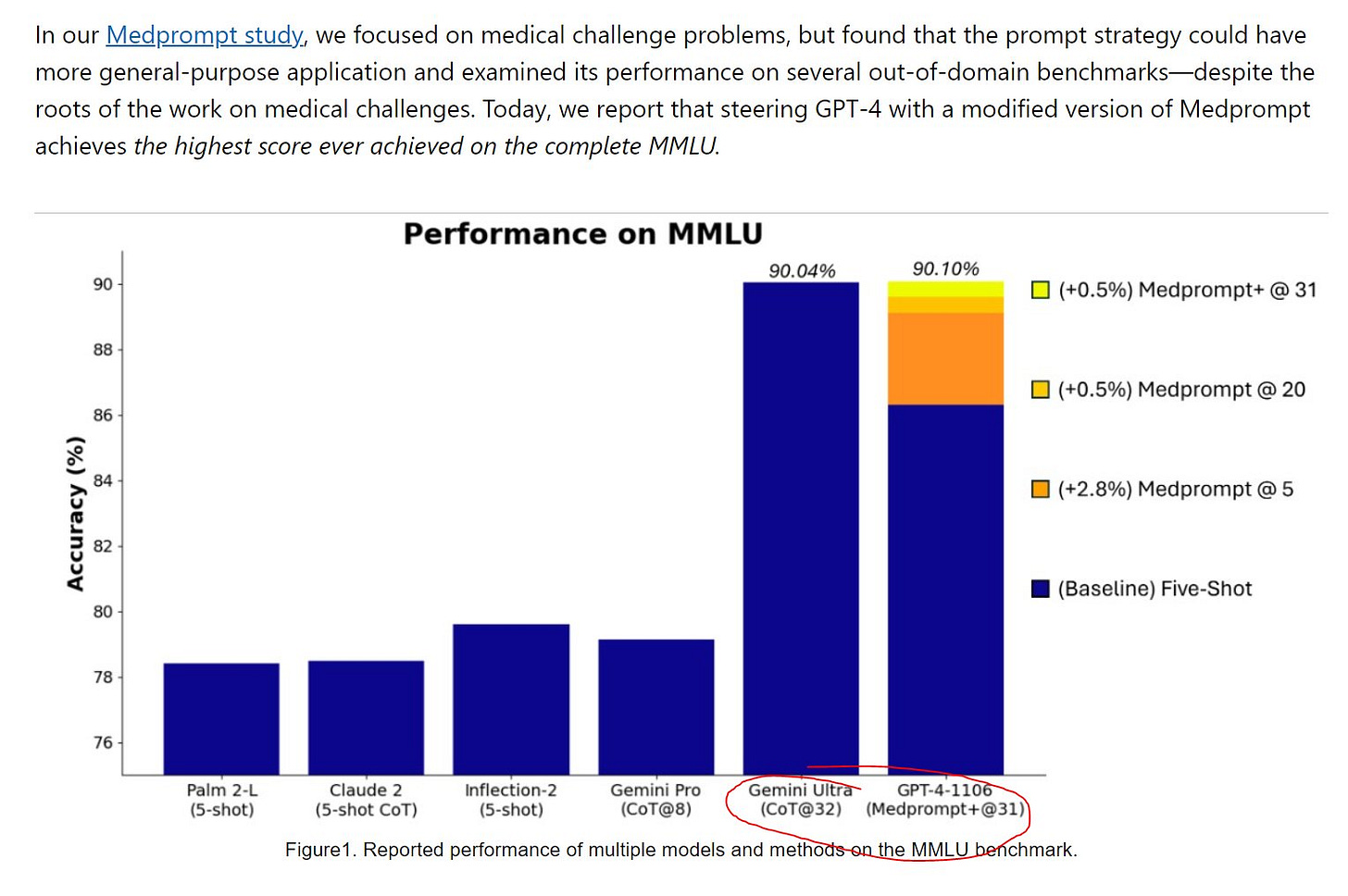

עם ההשקה של Gemini Ultra, מודל הדגל של גוגל, הם התגאו בכך שהמודל עוקף את GPT-4 במבחן הזה וזכו לכותרות רבות בעקבות ההישג המרשים (כולל אצלי בפיד).

אבל - לאחר כמה ימים חוקרי OpenAI, שלא יכלו לשאת את העלבון, המשיכו לנסות את אותו המבחן עם פרומפטים שונים ולבסוף הצליחו להעלות את הציון שלהם ולזכות בכתר בחזרה, כפי שתוכלו לראות בגרף הזה:

אז איך בכל זאת ניתן לקבוע מיהו המודל הטוב ביותר?

זו כמובן שאלה מורכבת. התשובה תלויה בהרבה משתנים: מהי המשימה, מה התחום עליו שואלים, מי כותב את הפרומפטים ועוד. אחת משיטות ההשוואה שצוברת פופולאריות בתקופה האחרונה היא שימוש ב"חוכמת ההמונים" ליצירת סוג של תחרות בין המודלים. האתר המוביל בתחום נקרא Chatbot Arena.

הכירו את Chatbot Arena - "זירת הקרב" של מודלי השפה.

איך זה עובד?

👈 המשתמש נכנס לאתר שלהם ורואה מסך צ'אט מפוצל לשניים. מאחורי הקלעים, המערכת בוחרת עבורו באקראי שני LLMs מתוך 20 המודלים המובילים ומציגה אותם אחד ליד השני מבלי לגלות באיזה מודלים מדובר.

👈 המשתמש מנסה להתקיל את המודלים עם השאלות הקשות ביותר שלו ומקבל תשובות משניהם במקביל, הוא יכול להמשיך את השיחה כמה שירצה.

👈 בסוף כל השיחה המשתמש מדרג איזה מודל ענה יותר. הם עושים את זה שוב ושוב על פני אלפי משתמשים וכך מחשבים את ציון ה-Elo של כל מודל (ציון שהוא דרך מקובלת לדרג שחקנים באופן יחסי בתחרויות של משחקים כמו שחמט)

מאז שהאתר הושק כבר מעל 100,000 משתמשים השתתפו בתהליך השיחה כך שמדובר במדגם סטטיסטי מספק.

בתמונה המצורפת תוכלו לראות סנפאשוט של ה-Leaderboad נכון להיום.

כפי שניתן לראות, ישנה התאמה יחסית גבוהה בין ציון הMMLU לציון ה-Elo, כאשר המודלים הסגורים GPT-4 וקלוד מובילים את הטבלה.

אבל ההפתעה הכי גדולה בטבלה הזו היא הציון הגבוה שקיבל מודל הפתוח החדש של חברת Mistral הצרפתית , Mixtral 8x7B.

המודל הצליח לעקוף את המודל הפשוט של גוגל Gemini Pro ולהשתוות ל- GPT-3.5, כלומר 50% ממי שהשתתף בתחרות טען שהמודל מנצח את ג'יפיטי.

ומה מיוחד במודל של מיסטרל?

מעבר לכך שמדובר במודל הפתוח הכי גדול שיצא עד היום, הוא גם בנוי בצורה קצת שונה מרוב המודלים ומשתמש בשיטה עבודה שנקראת Mixture of Experts.

בפשטות - במקום שהטקסט ששלחנו יוכנס למודל אחד גדול שמאומן על מגוון גדול של דאטה ויחזיר לנו תשובה, הם יצרו הרבה מודלים קטנים שכל אחד מהם אומן להיות מומחה בתחום ספיציפי.

הטקסט שהמשתמש כותב מועבר לסוג של ראוטר שמנתב אותו לתתי-מודלים הכי הרלוונטיים ולאחר מכן מעבד את התשובה ומחזיר אותה. על פי הדלפות, זו שיטה שקיימת גם בGPT-4.

יהיה מעניין לראות האיך השיטה הזו תהפוך להיות נפוצה יותר בעקבות ההצלחה של המודל של Mistral.

רוצים להשתתף בעצמכם? הנה הלינק