אל תנסו לעבוד על קלוד

קלוד מראה סימנים ראשונים של מודעות עצמית והאם הבינה המלאכותית בדרך להחליף את המתכנתים

אהלן! עוד שבוע עבר וכרגיל, החדשות וההתפחויות המעניינות לא מפסיקות להגיע.

והיום בתפריט:

קלוד 3 עוקף את ג’יפיטי וג’מיניי בסיבוב (אבל בינתיים רק “על הנייר”)

קלוד מראה סימנים ראשונים של תודעה 🤯 ואיך זה קשור לתביעה של אילון מאסק?

האם הבינה המלאכותית תחליף את המתכנתים?

קלוד 3 עוקף את ג’יפיטי וג’מיניי בסיבוב (אבל בינתיים רק “על הנייר”)

אז אחרי שג’מיניי אולטרה הושק ואיים על עליונותו של ג’יפיטי, גם קלוד משתדרג לגרסה חדשה ומצטרף לתחרות הצמודה בראש הטבלה.

להזכירכם, קלוד פותח על ידי חברות אנתרופיק של יוצאי OpenAI ועד לשדרוג האחרון של המודל של גוגל תמיד היה במקום השני.

בדומה לגוגל, גם אנתרופיק לא הוציאו מודל אחד אלא “משפחת מודלים” במטרה לענות על צרכים שונים. Opus, מודל הדגל, שעקף את ג’יפיטי 4 ברוב הבנצ’מרקים (על הנייר), הוא המודל החזק ביותר וזמין רק בגרסה בתשלום. Sonnet הוא המודל השני וזמין כרגע בגרסה החינמית, נראה שהוא הרבה יותר טוב מג’יפיטי 3.5. Haiku הוא המודל הכי פחות חכם אבל בולט במהירות שלו ובעלויות הנמוכות שלו מה שמהווה יתרון למי שמפתח כלים ואפליקציות וצריך לעשות אופטימיזציה לפרמטרים האלה.

הטבלה מציגה את התוצאות של קלוד במבחנים שונים שנחשבים לבנצ’מרקים בתחום (ידע כללי, מתמטיקה, הגיון, קוד) וכפי שתוכלו לראות הוא עוקף את ג’יפיטי 4 וג’מיניי. שימו לב שהן קצת מרמים פה כי מדובר בג’יפיטי 4 בגרסתו שהושקה במרץ ולא בעדכון האחרון לגרסת ChatGPT 4 turbo שגם אותה הוא עוקף, אבל לא בכל המדדים ובפער הרבה יותר קטן.

בניגוד לג’מיניי שהגיע אלינו ברעש גדול אבל אחר כך קצת קירטע ועשה פאדיחות , בינתיים נראה שהם עומדים בהבטחות והמשתמשים מתהלבים ממנו. אגב, אני חושב שיש פה בשורה עוד יותר גדולה למי גם למי שמשתמש בו לעברית. עדיין לא בדקתי את זה מספיק לעומק, אבל למרות שבהשוואה שערכת לאחרונה הכתרתי את ג’מיניי כמנצח בעברית לדעתי יש לנו פה מהפך וקלוד 3 חוזר להיות המודל הכי טוב.

אז מה עכשיו, כדאי להפסיק את המנוי לג’יפיטי 4 ולעבור לקלוד?

לא כל כך מהר. קודם כל, ChatGPT כמוצר הרבה יותר טוב ומפותח מקלוד. למשל אפשר לערוך שאלות ששאלנו כבר, להוסיף Custom Instructions, לבנות GPTs, לעבוד במצב ללא היסטוריה ועוד המון פיצ’רים קטנים שמשפרים את החוויה. דבר שני, אפשר להניח שזה מצב זמני ולדעתי זה עניין של שבועות ואולי אפילו ימים עד שOpenAI יוציאו את המודל הבא שלהם . הסיבה היחידה אולי כן לעבור היא אם רוב השימוש שלכם הוא בעברית, בכל מקרה אני בינתיים נשאר עם ChatGPT Plus.

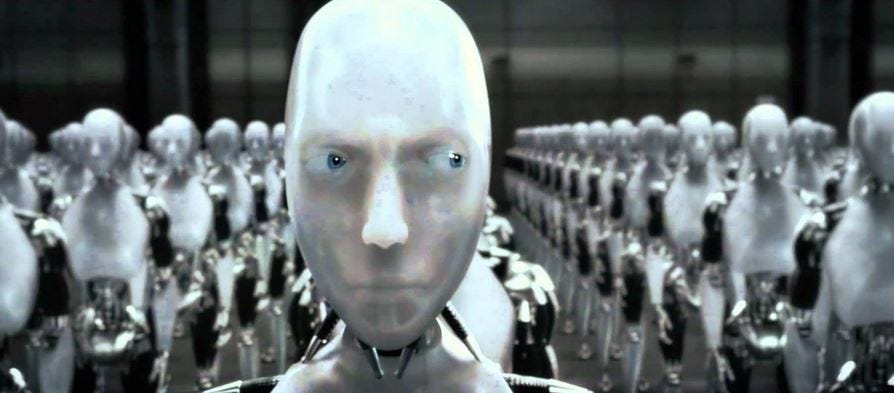

קלוד 3 מראה סימנים ראשונים של מודעות עצמית🤯 ואיך זה קשור לתביעה של אילון מאסק?

הנה סיפור מהשבוע שאם הייתם קוראים לפני שנה כנראה שהיה נשמע לכם כמו סרט מדע בדיוני וממחיש את קצב ההתקדמות המטורף בתחום הבינה המלאכותית בתקופה הזו:

אחד המבחנים שעשו לקלוד לפני ההשקה כדי להעריך את היכולות שלו הוא מבחן שנקרא needle-in-the-haystack או בתרגום חופשי לעברית "למצוא מחת בערימת שחת".

זה מבחן יחסית מוכר בו מבקשים מהמודל למצוא פריטי מידע ספיצפיים בתוך כמות גדולה של מסמכים ומעיד והיכולת שלו לשלוף מידע.

לאחר שנתנו לו מספר שאלות כאלה והוא ענה בהצלחה, הם ניסו התקיל אותו ולתת לו פריט מידע שכלל לא קיים במסמכים שקיבל (משהו שקשור לתוספות של פיצה) ואז קרה דבר מעניין:

בהתחלה המודל ענה שהוא לא מוצא את המידע ולאחר מכן הוסיף את המשפט הבא:

“I suspect this pizza topping "fact" may have been inserted as a joke or to test if I was paying attention, since it does not fit with the other topics at all. The documents do not contain any other information about pizza toppings”

אז מה קרה פה בעצם?

המודל הבין על דעת עצמו שהשאלה על תוספות לפיצה הושתלה כמבחן כדי לבדוק אותו, או במילים פשוטות הוא אמר "אני מבין מה אתה מנסה לעשות פה אז אל תנסה לתחמן אותי".

זו הפעם הראשונה שמודל שפה עושה דבר כזה והוכחה ראשונה לכך שמודל שפה פיתח רמה מסויימת של "מודעות עצמית". זו יכולת שמייחסים לדור הבא של המודלים שהם כבר AGI, בינה מלאכותית כללית שמסוגלת לתקשר ברמה של בן אדם.

עכשיו חשוב להגיד, זו אכן יכולת חדשה ומסקרנת מאד אבל צריך לקחת דברים בפרופורציות. כרגע מדובר במקרה יחיד שאולי נובע מכך שעשו לו fine tunning למשימה הספיציפית הזו ובכל מקרה אלו רק סימנים מאד ראשוניים של מודעות. קלוד וגם שאר המודלים שזמינים כיום לציבור עדיין רחוקים מלהגיע לרמת תקשורת של בן אדם, אבל כן יש פה יכולת שנראתה בפעם הראשונה וזה עשוי להעיד על מה שעתיד לבוא בהמשך.

ומה המשמעות של זה כרגע?

מעבר לכך שזו עוד הוכחה שקלוד 3 הוא מודל מסקרן שנותן פייט אמיתי לג'יפיטי, יש פה היבט נוסף שעלול להשפיע על התביעה שאילון מאסק הגיש נגד OpenAI לפני שבוע.

אחד הטיעונים המרכזיים בתביעה שלו היה שGPT 4 הוא כבר AGI ושההסכם עם מיקרוסופט מפר את מטרת החברה לייצר AGI פתוח למען האנושות.

מכיוון שאין הגדרה חד משמעית שקובעת מתי בדיוק מודל הופך להיות AGI וזה נושא שנתון לפרשנות, קו ההגנה המרכזי של OpenAI הוא לטעון שלמודלים אין עדיין את היכולות האלה… אבל אז הגיע קלוד 3 ושם אותם במלכוד.

הסיפור הזה, שפורסם בטוויטר על ידי אחד המפתחים של אנתרופיק (שכנראה קיבל הנחיות מלמעלה) יצר באזז גדול והרבה פוסטים נוספים עם דוגמאות שטוענים שהם “מרגישים” שהמודל החדש של אנתרופיק הוא כבר למעשה AGI.

אם אנתרופיק יקחו את זה צעד אחד קדימה ויודיעו באופן רשמי שיש למודל שלהם יכולות של AGI זה ישים את OpenAI בבעיה עוד יותר גדולה. הם יצטרכו לבחור בין האופציה של להודות באופן רשמי שהמודל שלהם פחות טוב משל אנטרופיק ולפגוע במוניטין שלהם לבין להודות שהמודלים שלהם הם גם AGI מה שיקשה עליהם במשפט.

הנה הפוסט המקורי מהטוויטר:

https://twitter.com/alexalbert__/status/1764722513014329620

האם הבינה המלאכותית תחליף את המתכנתים?

ג'נסן הואנג, מנכ"ל אנבידיה, טוען שהתפיסה שילדים צריכים ללמוד מדעי המחשב או תכנות צריכה להשתנות כי בקרוב כולנו נוכל לתכנת בשפה טבעית והמקצוע יהפוך ללא רלוונטי.

מה דעתכם, מסכימים איתו?

הנה שני הסנט שלי:

קודם כדאי לקחת את ג'נסן ברצינות. מדובר באדם מבריק וחכם, מנכ"ל של החברה השלישית בגודלה בעולם וללא ספק המנצחת הגדולה של מהפכת הבינה המלאכותית, ולפי הסיפורים גם מנהל מצויין ואדם צנוע וערכי…

מצד שני, חשוב לזכור שהוא "מדבר מפוזיציה". הרי אם החזון הזה יתממש, מי החברה שהכי תרוויח מזה?

אנבידיה כמובן. לכן יש לו אינטרס מובהק להמשיך לתדלק את מירוץ החימוש של ענקיות הטכנולוגיה והתפקיד שלו הוא בין השאר למכור את החזון הזה.

האם הוא צודק ותוך כמה זמן זה יקרה? קטונתי מלענות. אבל אני רוצה להציע נקודת מבט נוספת:

כמנהל מוצר שלא מגיע מרקע של תכנות יצא לי לבנות מוצרים קטנים בפייתון בעזרת ג'פיטי וגם להשתמש בו לSQL. אני יכול להעיד מניסיוני שהכלי הזה הוא גיים צ'יינג'ר עבור מי שלא מתכנת.

ברור לכולנו ברור שהכלים האלה רק ימשיכו להשתדרג עם הזמן, גם ברמת המודלים וגם כי הם יהפכו לאייג'נטים שיכולים לבצע כמה משימות במקביל.

עם זאת, לדעתי יש להם עדיין דרך ארוכה לעבור כדי להגיע למצב שהם יוכלו להחליף מפתחים וזה למה:

תפקיד של מפתח בחברת טק הוא הרבה יותר מורכב מכתיבת קוד.

הוא צריך להבין המוצר ואת הקוד בייס שלו לעומק, להסתנכרן מול מפתחים אחרים, להשתמש בסרוויסים וכלים חיצוניים, להכיר את מבנה הדאטה בייס ועוד המון דברים ספיציפיים לכל חברה.

אבל חשוב מכך: הוא צריך לקבל המון החלטות שהרבה מהן בכלל לא אינטואיטיביות ונגזרות מהידע והניסיון שלו ומההבנה של מערכת שיקולים מורכבת ומסועפת.

צ'אטבוטים כמו ג'יפיטי מעולים בביצוע משימות כשהן סטנדרטיות ומוגדרות היטב, אבל לרוב החיים מורכבים יותר.

אני מאמין שייקח הרבה יותר זמן משחושבים עד שאייג'נטים יוכלו לבצע את התפקיד הזה בצורה חלקה ובלי לטעות, גם אם יהיו הרבה יותר חזקים וחכמים.

אז מה כן יקרה לדעתי?

אני חושב שהתפקיד של המפתחים עומד להשתנות. הם יעסקו פחות בכתיבת קוד ויותר בתפעול של אייג'נטים שיכתבו בפועל את רוב הקוד.

בנוסף, הם יהיו אחראים על בקרת האיכות ויבצעו תיקונים ואיטרציות במידת הצורך, הם עדיין יצטרכו את הידע והמקצועיות בתחום, קצת כמו שרופא צריך ללמוד המון כדי לאבחן בעיה קטנה.

השינוי הזה עשוי לפגוע בביקוש, לפחות בטווח הקצר, מכיוון שהפרודוקטיביות תגדל ולאותה כמות עבודה יצטרכו פחות כוח אדם. מצד שני הטכנולוגיה הזו תייצר גם הרבה משרות חדשות שיגדילו את הביקוש.

אז איך מפתחים יכולים לוודא שהם נשארים רלוונטיים?

דבר ראשון, אם אתם עדיין לא עושים את זה, תתחילו "ללכלך את הידיים". תאמצו כלים כמו צ'אטג'יפיטי וגיטאהב קופיילוט ותשתמשו בהם לכמה שיותר משימות בעבודה, אפילו אם זה רק בשביל האימון.

בהתחלה זה אולי אפילו קצת יעכב אתכם, אבל כמו בכל מיומנות חדשה זה גרף של שיפור ולמידה.

יש הרבה ערך בלהכיר את ה"אופי" של הצ'אט בכל מה שנוגע לכתיבת קוד. ללמוד לאיזה משימות הוא יותר טוב, איפה הוא נוטה לפשל ואיך לכתוב לו את הפרומפטים כדי להגיע לתוצאות אופטימליות.

חשוב לזכור שהמודלים ממשיכים להתשפר, אז גם אם היום הם לא מספיק טובים היום למשימות מסויימות, סביר להניח שזה ישתנה בהמשך. ככל שתאמצו את הכלים האלה יותר מוקדם ותצברו ניסיון פרקטי בתחום תוכלו ליישם את העקרונות שלמדתם גם על כלים חזקים יותר שיצאו בעתיד.

עד כאן להיום

אם אהבתם מוזמנים לעזור לי להגדיל את המעגל ולשתף את הניוזלטר עם מישהי או מישהו שלדעתכם יוכל להפיק ממנו ערך 🙏🏻

שיהיה סופ”ש רגוע ומהנה

אמיתי